Ya en los años 50 se empezó a hacer de dominio público la posibilidad de incluir en imágenes y sonidos, mensajes que no eran perceptibles por el consciente, pero que quedaban grabados e influían a nivel subconsciente. El primer mensaje de este tipo que se hizo famoso fue el enorme letrero de “drink Coke” que colaron en medio de dos fotogramas en el cine, y que se veía durante una fracción de segundo. James Vicary fue el autor de este estudio en particular, pero después de publicar sus conclusiones, se retractó de las mismas, y el asunto quedó en el aire.

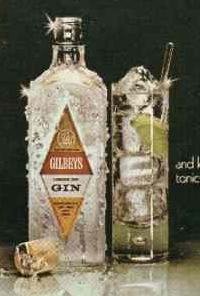

En la imagen que acompaña a este artículo podemos ver un cartel con un mensaje subliminar oculto. ¿Lo veis? Tomaros unos segundos antes de seguir leyendo, a ver si lo encontráis... En efecto, se puede apreciar sutilmente la palabra “sex” inscrita en los cubitos de hielo.

Otra ocasión muy sonada fue la de la campaña electoral Bush-Gore del año 2000 en Estados Unidos. Los demócratas acusaron a los republicanos de incluir mensajes subliminares en sus anuncios publicitarios. Los republicanos no lo negaron, porque además era cierto que lo habían hecho, pero respondieron que no había nada de malo en ello porque la llamada influencia subliminar no estaba completamente demostrada. Y en esto último tenían razón.

Hemos tenido que esperar hasta mayo de 2005 para ver por primera vez un estudio bastante completo y concluyente que pone en evidencia el poder de este tipo de mensajes. El trabajo en cuestión, publicado en el Proceedings of the National Academy of Sciences, no sólo pone de manifiesto la influencia de los mensajes subliminares, sino que además da una medida concreta a esta influencia.

Se aprovecharon las pruebas preliminares que se estaban haciendo a tres pacientes con epilepsia. En primer lugar les colocaron electrodos esperando percibir actividad eléctrica de las partes del cerebro relacionadas con el miedo. Los pusieron delante de una pantalla de ordenador, donde proyectaron palabras neutras (“primo”, “ver”...) que intercalaban con secuencias instantáneas de otras palabras como “peligro” o “matar”. Estas últimas se emitían durante 1/30 segundos; casi imperceptibles. Sin embargo en todos los casos se registró actividad eléctrica en la amígdala cerebral, que está directamente relacionada con el miedo, cada vez que se emitía una de las palabras subliminares. Estos hallazgos ponen claramente de manifiesto que el significado emocional de las palabras tiene acceso a nuestro cerebro también a nivel subconsciente, y que nuestro cuerpo reacciona acorde con dichas emociones implícitas.

“¿Llevaba razón Vicary?”, se pregunta Joel Cooper de la Universidad de Princeton. “Nuestros hallazgos, junto con un creciente cuerpo de conocimiento en estudios sociales, sugieren que puede haber alguna verdad en la propuesta de que nuestros estados emocionales se vean afectados por estímulos recibidos pre-conscientemente”.